🌟 1-1 生成AIとは?

- 生成AIは、様々な種類の新しいデータを生成できる。

- LLMは生成AIの一部で、テキスト生成に特化している。

- Transformerは、LLMが文脈を理解するのに重要な役割を果たす技術。

- LLMは、事前学習とファインチューニングの学習方法がある。

- RAGは、LLMが外部の知識を使って、より正確な回答を生成する技術。

生成AI (Generative AI)

大規模言語モデル (LLM - Large Language Model)

Transformer

事前学習 (Pre-training)

ファインチューニング (Fine-tuning)

RAG (Retrieval Augmented Generation)

🤖 生成AIとは何か?

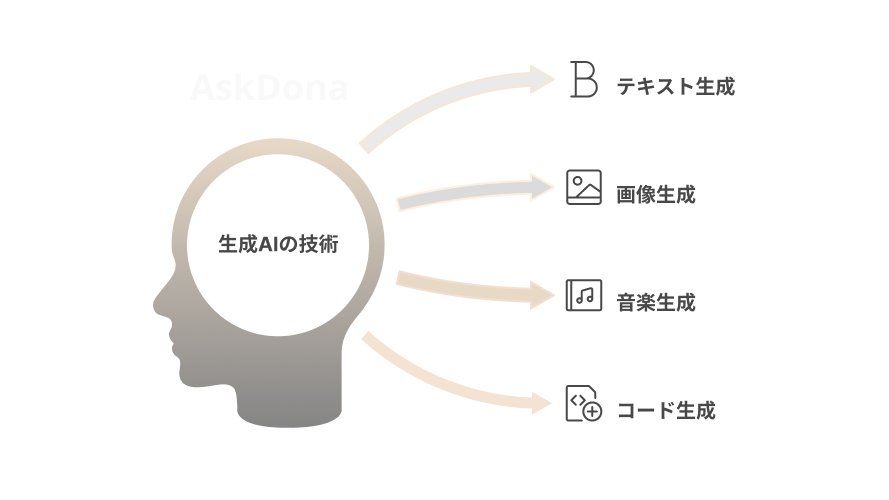

生成AI (Generative AI) は、テキスト、画像、音楽、プログラムコードなど、様々な種類の新しいデータを生成する人工知能技術の総称です。例えば、指示に基づいて絵を描いたり、音楽を作曲したり、文章を書いたりすることができます。

生成AIの中で、特にテキストデータの生成に特化した技術を、大規模言語モデル (LLM - Large Language Model) と呼びます。LLMは、膨大なテキストデータを学習することで、人間のような自然で流暢な文章を生成する能力を獲得しています。有名な例としては、ChatGPT、Gemini、Claudeなどがあります。

💡 LLMの基盤技術:Transformer

LLMの性能向上に大きく貢献しているのが Transformer と呼ばれる技術です。Transformerは、文章中の単語同士の関係性や文脈を理解することに優れており、より自然で高精度なテキスト生成を可能にしています。

「Transformer」という仕組みを提案した論文「Attention Is All You Need」は、Googleの研究者ら(L. Kaiser et al., 2017)による有名な論文で、「アテンション」という��機構を大規模に活用したトランスフォーマーを提案しています。

Sakana AIの創業者の一人であるLlion Jones氏は「Attention Is All You Need」の著者の一人でもあります。

📚 LLMの学習プロセス

LLMは、以下の2つの学習方法で精度を高めます:

-

事前学習 (Pre-training)

ニュース記事、ウェブページ、書籍、Wikipediaなどの膨大なテキストデータを使って、LLMに一般的な言語知識を学習させます。この段階では、LLMは大量のテキストデータから、単語の意味、文法、言葉の繋がり方などを学びます。 -

ファインチューニング (Fine-tuning)

特定のタスクに特化してLLMを訓練します。例えば、翻訳、要約、質問応答など、それぞれのタスクに特化したデータセットを使って学習させ、モデルを特定のタスクや用途に最適化します。

🌐 RAG技術とは?

近年注目されているのが RAG (Retrieval Augmented Generation) という技術です。RAGは、LLMが学習していない外部のデ��ータベースや資料から関連情報を抽出し、その情報に基づいてLLMに回答を生成させます。これにより、LLM単体では難しかった、社内資料の情報や最新の情報に基づいた質の高い回答を生成することが可能になります。

RAGの有用性について詳しくは第三章でご説明します。